[Paper Review] DCNv2 : Deformable Convolutional Networks v2

기존 DCN(Deformable Convolutional Networks) 설명은 아래 포스팅을 참고하기 바란다.

Github : github.com/CharlesShang/DCNv2

CharlesShang/DCNv2

Deformable Convolutional Networks v2 with Pytorch. Contribute to CharlesShang/DCNv2 development by creating an account on GitHub.

github.com

Paper : arxiv.org/pdf/1811.11168.pdf

1. Introduction

DCN의 특징은 객체(Object)의 기하학적 변형(the geometric variations of objects)에 적응하는 능력이 탁월하다는 것이다. 하지만 스케일, 포즈, 시점, 객체의 부분적 변화 등으로 인한 기하학적 변화가 일어나는 객체 탐지 영역에서 내가 원하는 객체의 모양에 맞게 딱 검출하는 건 참 어려운 일이다.

이러한 문제점을 해결하기 위해서 나온 것이 바로 DCN v1 인데, 두 가지 모듈이 존재한다. 첫번째 모듈은 deformable convolution 으로 standard conv 의 그리드 샘플링 위치는 선행된 특징맵(feature map)과 관련하여 학습된 변위로 각각 offset 이 적용된다. 두번째 모듈은 Roolpooling 에서 빈 위치에 대한 offset 이 학습되는 deformable Rolpooling 이다. 이러한 모듈을 신경망에 통합하면 객체에 대한 올바른 특징을 적용 시킬 수 있다. 이러한 접근 방식은 객체 탐지 정확도가 크게 향상된다.

그러나 기존 DCN v1 은 객체에 대한 커버리지가 정확하지 않기 때문에 관심 영역을 훨씬 벗어난, 객체의 특징(feature)과 관련 없는 영역이 검출 될 수 있는 문제가 존재한다. 이러한 문제를 해결하기 위해 향상된 모델링과 더 강력한 학습을 통해 관심 영역에 집중할 수 있도록 한 Deformable ConvNets v2 구조를 제안한다. 신경망 내에서 DCN을 포괄적으로 통합하고 deformation modeling 범위를 확장하는 modulation mechanism 을 도입함으로써 모델링 능력을 향상시켰다.

기존 DCNv1 에 비해 향상된 모델링 성능을 제공하는 DCNv2는 두가지 형태로 제공된다. 첫번째는 신경망 내에서 deformable convolution layer의 사용이 확장되었다는 것이다. 보다 더 많은 컨볼루션 레이어에 offset learning capacity 를 허용한다면 DCNv2 가 더 넓은 범위의 특징 수준에서 객체 영역에 대한 샘플링을 제어 할 수 있게 된다. 두번째는 DCN 모듈의 modulation mechanism 으로 각 샘플은 학습된 offset 을 갖고 있을 뿐만 아니라, 학습된 특징 진폭?(amplitude) 범위?에 의해 변형된다. 따라서 신경망의 모듈은 공간 분포와 샘플의 상대적 영향을 모두 고려할 수 있다.

DCNv2의 증가된 모델링 용량을 최대한 활용하려면 효과적인 학습이 필요한데, 본 논문에서는 R-CNN을 teacher 로 사용한다. 이 R-CNN은 애초에 입력된 cropped image 에 대해 분류하기 위해 학습된 신경망이라서, 관심 영역 외의 배경 정보가 적기 때문에 관심 영역 이외 정보에는 영향을 받지 않는다는 점을 이용하여 특징을 학습시킨다. 이러한 방식으로 DCNv2는 향상된 샘플링이 가능하다. 이 모델은 경량으로 유지되며 기존 신경망 구조에 쉽게 통합될 수 있다. 특히 DCNv2를 다양한 백본 신경망에 사용하여 Faster R-CNN 및 Mask R-CNN 시스템에 통합 할 수 있다.

2. Analysis of Deformable ConvNet Behavior

2.1 Spatial Support Viualization

Effect receptive fields

신경망 노드의 receptiv field 내의 모든 픽셀이 샘플링에 있어 동일하게 기여되진 않는다. 이러한 기여도의 차이는 effective receptive field 에 의해 표현되며, 각 이미지 픽셀의 intensity perturbation 에 대한 node response의 기울기로 계산이 된다. 신경망 노드에서 개별 픽셀이 가지는 영향이 어떤지 알기 위해 effective receptive field를 사용하게 되지만, 이는 전체 이미지 영역이 어떤 영향을 주는지에 대해서는 반영하지 않는다.

Effective sampling / bin locations

DCNv2에서 stacked convolutional layers 의 샘플링 위치와 Rolpooling 레이어의 샘플링 bin 은 DCN의 동작을 이해하기 위해 시각화 될 수 있다. 그러나 이러한 샘플링의 위치가 신경망 노드에 미치는 영향은 아직 밝혀지지 않았다. 대신 샘플링 및 bin 위치에 대한 신경망 노드의 기울기로 계산된 정보를 통해 정확한 객체의 영역을 잡는데 있어서 어떤 영향을 미치는지 알 수 있다.

Error-bounded saliency regions

image saliency에 대한 최근 연구에서 입증된 바와 같이, 신경망 노드에 영향을 미치지 않는 이미지 영역을 제거해도 신경망 노드의 response 는 변경되지 않는다고 한다. 여기서 image saliency 란 왼쪽 예시를 보면 이해가 확 갈 것이다. 이러한 속성을 기반으로 노드의 support region 을 small error bound 내에서 전체 이미지와 동일한 response 를 제공하는 가장 작은 이미지 영역으로 결정할 수 있다.

영어를 번역한거라 번역이 이상한데, 다시 말하자면 왼쪽 사진과 같이 검출된 image saliency 즉 heatmap 양상에 영향을 미치지 않을 것 같은 가장 왼쪽 영역 및 가장 오른쪽 영역을 제거하여 image saliency 를 검출해도 전체 결과는 자르나 안자르나 똑같기 때문에 되도록 결과에 영향을 미치지 않는 가장 적절한 영역(=가장 작은 이미지 영역)을 사용할 수 있다는 말이다.

여기서 최종 객체를 검출하는데 있어서 가장 쓸떼 없는 영역(이라고 부르고 싶다)을 error-bounded saliency region 이라고 칭하며, 이미지의 일부를 점진적으로 마스킹하여 node response 를 계산 할 수 있다.

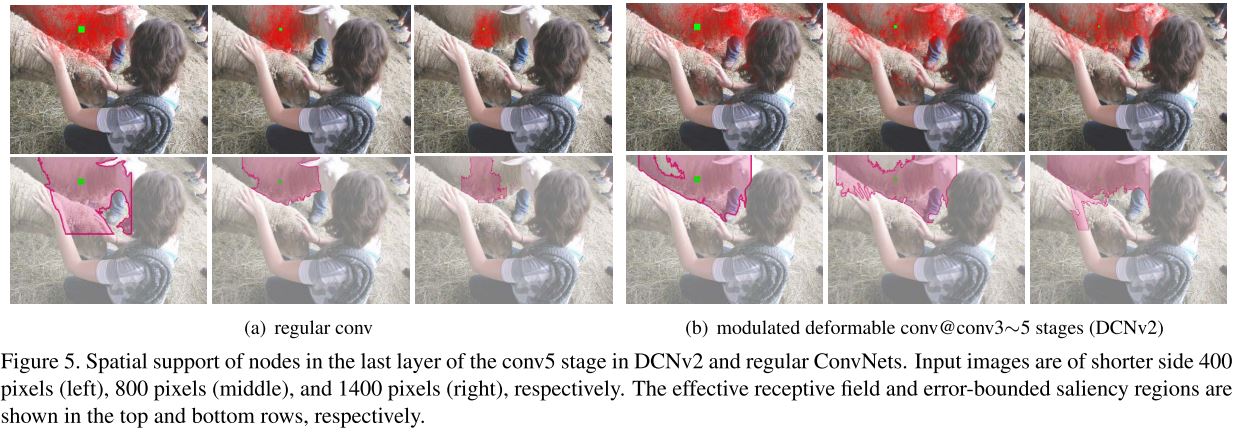

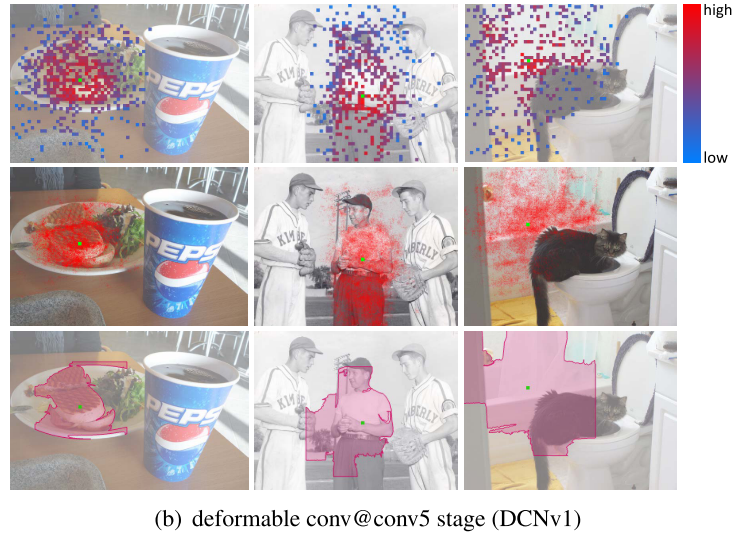

2.2. Spatial Support of Deformable ConvNets

regular conv 는 RolPooling이 align 된 Faster R-CNN + ResNet-50 객체 탐지기로 구성되는데 ResNet-50의 모든 컨볼루션 레이어는 전체 입력 이미지에 적용된다. conv5 단계의 stride 는 feature map resolution 을 높이기 위해 32 픽셀에서 16 픽셀로 감소된다. RPN 헤드는 ResNet-101의 conv4 특징 위에 추가되고, conv5 특징 위에 aligned RolPooling과 두 개의 FC 레이어로 구성된 Fast R-CNN 헤드를 추가 한 다음 classification 및 bounding box regression branch 를 추가한다. 객체 탐지기를 DCN으로 바꾸려면 conv5 단계에서 3x3 컨볼루션의 세 레이어는 DCN 으로 대체된다. 또한 Rolpooling 레이어는 deformable RolPooling 으로 대체된다. 두 신경망은 모두 COCO 벤치마크에서 학습되고 시각화 된다. 세 가지 시각화 방법을 사용하여 그림 1 (a) ~ (b) 에서 conv5 단계의 마지막 계층에서 노드의 spatial support 양상을 볼 수 있다. 샘플링 위치도 표시된다. 이러한 시각화를 통해 알 수 있는 것은 다음과 같다.

1. regular conv 는 기하학적 변화를 어느정도 모델링 할 수 있다. Deep Conv 의 강력한 representation 때문에 신경망 가중치는 어느정도의 기하학적 변환을 수용할 수 있도록 학습되는 것이다.

2. DCN을 도입함으로써 까다로운 COCO 벤치 마크에서도 기하학적 변환을 모델링하는 신경망의 성능이 크게 향상되었다. 이러한 spatial support 는 이미지에서 전경의 노드는 전체 객체를 덮을 수 있게 하고, 배경의 노드는 더 큰 context 를 포함할 수 있도록 하였다. 그러나 이러한 spatial support 의 범위는 부정확 할 수 있고, effective receptive field 및 검출과 관련 없는 배경 영역을 포함하는 전경 노드의 error-bounded saliendcy region 이 포함 될 수 있다.

3. DCNv1 에서 사용된 샘플링 위치보다 더 많은 정보를 제공 할 수 있다. 예를 들어 그리드를 따라 고정된 샘플링 위치를 가지고 있지만 실제로는 신경망 가중치를 통해 effective spatial support 를 적용하는 regular conv 에서 이를 확인 할 수 있다. 기존 DCNv1 처럼 샘플링 위치만 조사하게 된다면 DCN에 대한 잘못된 결론이 도출될 수 있음을 시사한다.

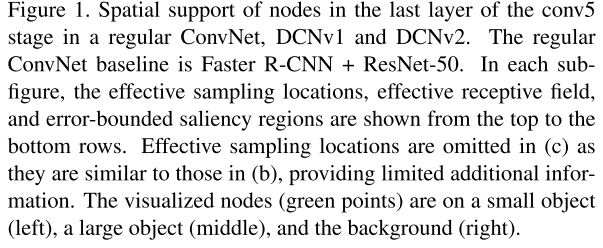

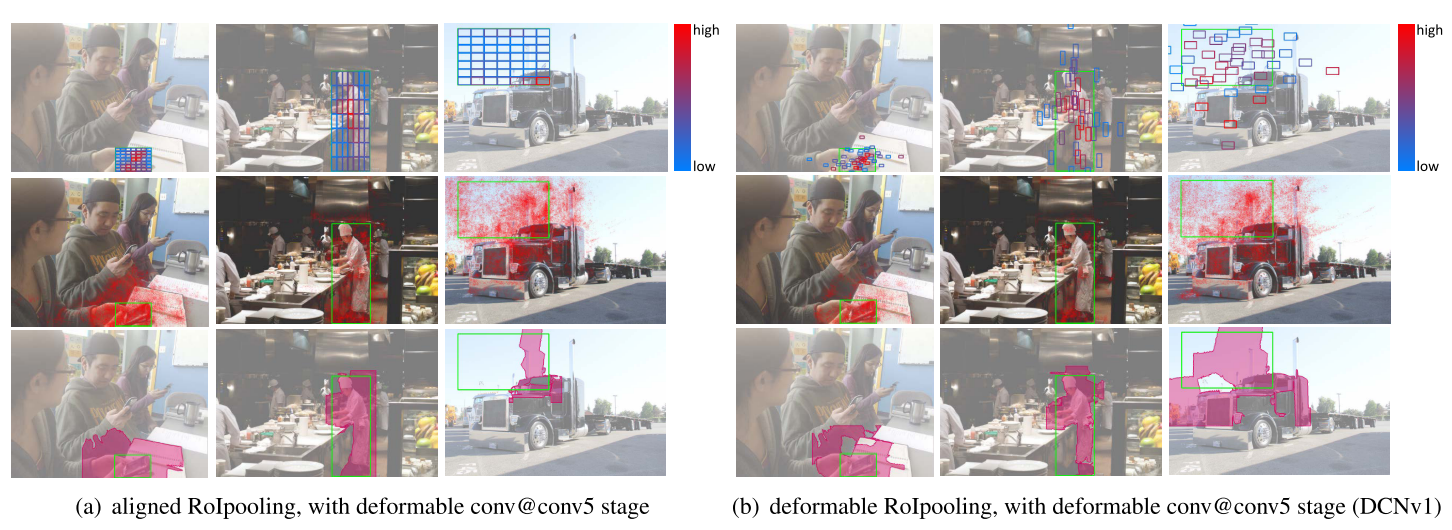

위 그림 (a) ~ (b)는 2 fully connected layer 의 spatial support 를 보여준다. 이는 classification 및 bounding box regression branch 가 바로 뒤따르는 각 RoI detection head 이다. deformable RoIpooling 에서는 학습 가능한 bin offset 도입 덕분에 aligned RoIPooling 보다 훨씬 더 많은 bin 들이 객체 전경을 덮게 된다. 따라서 bin 에서 더 많은 정보를 downstream Fast R-CNN head 에 사용 할 수 있다. 한편 마지막 그림을 보면, aligned RoIPooling 및 deformable RoIPooling 모두에서 error-bounded saliency region 은 객체 전경에 완전히 초점을 맞추지 않기 때문에 RoI 외부의 이미지가 예측 결과에 영향을 미친다는 것을 보여준다.

Deformable ConvNets 은 일반 ConvNets 에 비해 기하학적 변화에 적응하는 능력이 뛰어나며, saptial support 이 관심 영역을 넘어 확장될 수 있음을 알 수 있다.

3. More Deformable ConvNets

기하학적 변화에 적응하는 신경망의 성능을 향상시키기 위해 본 논문에서는 모델링 능력을 높이고 이러한 기능을 활용 할 수 있도록 다음과 같은 방법들을 제안한다.

3.1 Stacking More Deformable Conv Layers

Deformable ConvNets 가 까다로운 벤치마크에서 기하학적 변환을 효과적으로 모델링 할 수 있다는 것 기반하여 보다 일반적인 Conv 레이어를 deformable counterparts 로 대체한다. deformable conv layer 를 쌓아두면 전체 신경망의 기하학적 변환 모델링 능력이 더욱 강화 될 수 있다.

본 논문에서 ResNet-50 의 conv3, conv4 및 conv5 에서 3 x 3 conv layer 에 deformable conv 가 적용된다. 따라서 신경망에서 12개의 deformable convolution layer 가 있다. 비교적 간단하고 소규모의 PASCAL VOC 벤치마크에서 3개 이상의 레이어를 쌓을 때 성능이 포화(saturates)된다는 것이 관찰되었다. 이러한 실험에서 conv3 - conv5 단계에서 deformable layer 를 사용하면 COCO 에서 객체 탐지를 위한 정확성과 효율성 사이에서 최상의 균형을 이룰 수 있다고 한다.

3.2 Modulated Deformable Modules

spatial support region 을 다룰 때 deformable ConvNet 의 기능을 더욱 강화시키기 위해 modulation mechanism 이 도입되었다. 이를 통해 Deformable ConvNet 모듈은 입력 특징을 인식할 때 offset 을 조정할 수 있을 뿐만 아니라 다른 spatial location 및 bins 에서 입력 특징 진폭(amplitudes)을 변조 할 수 있다. 극단적인 경우에는 이러한 모듈은 특징 진폭을 0으로 설정하여 특정 위치 및 bins 에서 신호를 인식하지 않도록 결정할 수 있다. 결과적으로 해당 공간 위치의 이미지 콘텐츠는 모듈 출력에 영향을 미치지 않는다. 따라서 이러한 변조 메커니즘은 spatial support region 을 조정할 수 있는 또 다른 차원의 freedom 을 신경망 모듈에게 제공 할 수 있다.

K 샘플링 위치의 convolutioanl kernel 이 주어지면 $ w_{k} $ 와 $ p_{k} $ 가 각각 k 번째 위치에 대한 가중치와 미리 지정한 offset 을 나타낸다. 예를 들어 K = 9 및 $ p_{k} \in \left \{ \left ( -1, -1 \right ), \left ( -1, 0 \right ), ... , \left ( 1, 1 \right ) \right \} $ 은 3 x 3 convolutional kernel 인 dilation 1 을 정의한다. $ x(p) $ 및 $ y(p) $ 가 각각 입력 특징 맵 x 및 출력 특징 맵 y 에서 위치 p 의 특징을 나타낸다. modulated deformable convolution 은 다음과 같이 표현 할 수 있다.

$ y(p) = \sum_{k=1}^{K}w_{k}\cdot x(p + p_{k}+\bigtriangleup p_{k})\cdot \Delta m_{k} $

여기서 $ \bigtriangleup p_{k} $ 및 $ \Delta m_{k} $ 는 각 k 번째 위치에 대해 학습 가능한 offset 및 modulation scalar 이다. 이 modulation scalar 는 [0, 1] 범위에 있으며 offset 은 범위가 제한되지 않는 실수이다. $ p + p_{k}+\bigtriangleup p_{k} $ 를 계산할 때 bilinear interpolation 이 적용된다. $ \bigtriangleup p_{k} $ 및 $ \Delta m_{k} $ 는 동일한 입력 특징 맵 x 에 적용된 별도의 conv layer 를 통해 얻을 수 있다.

이 conv layer 는 현재 conv layer 와 spatial resolution 및 dilation 이 동일하다. 출력은 3K 채널이며 처음에 2K 채널은 학습된 offset $ \left \{ \bigtriangleup p_{k}\right \}_{k=1}^{K} $ 에 해당하고 나머지 K 채널은 sigmoid layer 에 추가로 공급되어 $ \left \{ \bigtriangleup m_{k}\right \}_{k=1}^{K} $ 를 얻게 된다.

이러한 separate convolution layer 의 커널 가중치는 0으로 초기화 되어 각 $ \bigtriangleup p_{k} $ 및 $ \Delta m_{k} $ 의 초기 값은 각각 0 과 0.5 가 된다. offset 및 modulation learning 을 위해 추가된 conv layer 의 학습률은 기존 존재하던 layer 의 0.1 배로 설정된다.

modulated deformable RoIpooling 의 설계도 비슷하다. 입력 RoI 가 주어지면 RoIPooling 은 이를 K 개의 spatial bins 으로 나눈다. (e.g. 7 x 7) 각 bins 내에서 일정한 공간 간격의 샘플링 그리드가 적용된다. (e.g. 2 x 2) 그리드에서 샘플링된 값은 bins 출력을 계산하기 위해 평균화된다. $ \bigtriangleup p_{k} $ 및 $ \Delta m_{k} $ 을 k 번째 bins 에 대한 학습 가능한 offset 및 modulation scalar 라고 한다. output binning feature $ y(k) $ 는 다음과 같이 계산된다.

$ y(k) = \sum_{j=1}^{n_{k}}x(p_{kj} + \Delta p_{k})\cdot \Delta m_{k}/n_{k} $

여기서 $ p_{kj} $ 는 k 번째 bins 에 있는 j 번째 그리드 셀의 샘플링 위치이고 $ n_{k} $ 는 샘플링된 그리드 셀의 수를 나타낸다. 특징 $ x(p_{kj} + \Delta p_{k}) $ 을 얻기 위해 bilinear interpolation 이 적용된다. $ \bigtriangleup p_{k} $ 및 $ \Delta m_{k} $ 의 값은 입력 특징 맵의 sibling branch 에 의해 생성된다. 이 branch 에서 RoIPooling 은 RoI 특징을 생성하고 그 뒤에 1024-D 의 두 fc layer(standard derivation 0.01 의 가우스 분포로 초기화됨) 가 뒤따르게 된다. 또한 additional fc layer 는 3K 채널의 출력을 생성한다. (가중치는 0으로 초기화)

처음 2K 채널은 정규화 된 학습 가능한 offset 이며 여기서 RoI 의 너비 및 높이와 함께 element-wise multiplication 이 적용되어 $ \left \{ \Delta p_{k} \right \}_{k=1}^{K} $ 을 얻는다. 나머지 K 채널은 sigmoid layer 에 의해 정규화 되어 $ \left \{ \Delta m_{k} \right \}_{k=1}^{K} $ 를 생성한다. offset 학습을 위해 추가된 fc layer 의 학습률은 기존 layer 의 학습률과 동일하다.

3.3 R-CNN Feature Mimicking

그림 2에서도 볼 수 있듯 RoI 별 classification node 의 error-bounded saliency region 은 일반 ConvNet 및 Deformable ConvNet 모두에 대한 RoI 로 확장될 수 있다. 따라서 RoI 외부의 이미지 컨텐츠는 추출된 특징에 영향을 미치고 결과적으로 객체 탐지의 최종 결과를 저하 시킬 수 있다.

Faster R-CNN 에서 객체를 탐지하는데 오류가 나는 그럴듯한 원인은 중복 컨텍스트(redundant context) 라는 것을 발견했다. 이에 Faster R-CNN 및 R-CNN 의 classification score 를 결합하여 final detection score 를 얻을 것을 제안하였다. R-CNN classification score 는 입력 RoI 에서 크롭된 이미지 콘텐츠에 초점을 맞추기 때문에 이를 통합하면 중복된 컨텍스트 문제를 완화시키고 탐지 정확도를 개선 시킬 수 있다고 했다. 그러나 통합 시스템은 Faster R-CNN 및 R-CNN 분기를 모두 학습 및 추론에 적용해야하기 때문에 느리다는 점을 지적했다. 한편 deformable ConvNet 은 spatial support region 을 조정하는데 강력하다. 특히 Deformable ConvNet v2 의 경우 modulated deformable RoIPooling 모듈은 중복 컨텍스트를 제외하는 방식으로 단순히 bin 의 modulation scalar 를 설정할 수 있다. 그러나 이러한 실험은 standard Faster R-CNN training 을 통해 이런 representation 을 잘 학습 할 수 없었다고 한다. 이는 기존의 Faster R-CNN 의 training loss 가 이러한 representation 을 효과적으로 학습할 수 없다고 했다. 이와 같은 학습을 위해서는 추가적인 지침이 필요하다.

Deformable Faster R-CNN RoI 별 특징에 loss 를 모방한 기능을 통합하여 크롭된 이미지에서 추출한 R-CNN 특징과 유사하게 만든다. 이러한 auxiliary training 목표는 R-CNN 과 같은 "focused" 특징을 학습하기 위해 Deformable Faster R-CNN 을 구동하기 위함이다. 그림 2에서 시각화 된 spatial support region 을 기반으로 초점을 맞춘 특징 표현이 이미지 배경에 부정적인 RoI에 적합하지 않을 수 있다. 배경 영역의 경우 오 탐지를 생성하지 않도록 더 많은 컨텍스트 정보를 고려해야 한다. 따라서 이렇나 손실은 GT 객체와 충분히 겹칠 때의 RoI 에서만 적용된다.

Deformable Faster R-CNN 학습을 위한 신경망 구조는 아래 그림 3과 같다.

이 구조에서 Faster R-CNN 신경망 외에도 기능을 모방하기 위해 R-CNN 분기가 추가된다. 이러한 RoI $ b $ 가 주어지면, 이에 해당하는 이미지 패치가 크롭되고 $ 224 \times 224 $ 픽셀로 크기가 조정된다. R-CNN 분기에서 백본 신경망은 크기가 조정된 이미지 패치에서 작동하고 $ 14 \times 14 $ saptial resolution 의 특징 맵을 생성하게 된다. modulated deformable RoIPooling layer 가 특징 맵 위에 적용되며 입력 RoI 는 크기가 조정된 전체 이미지 패치를 덮게 된다. (0, 0)의 왼쪽 상단 모서리 즉 높이와 너비는 224 픽셀이다.

그 후 1024-D 의 2 fc layer 가 적용되어 입력 이미지 패치에 대한 R-CNN 특징 표현 $ f_{RCNN}(b) $ 을 생성한다. classification 을 위해 (C + 1) - way Softmax classifier 가 뒤를 이으며, 여기서 C 는 foreground 카테고리 수를 나타내고 background 는 1개를 뜻한다. mimic loss 는 R-CNN 특징 표현 $ f_{RCNN}(b) $ 와 Faster R-CNN 의 대응 물인 $ f_{FRCNN}(b) $사이에 적용 된다. 이는 또한 1024-D 이며 Fast 에서 2 fc layer 에 의해 생성된다.

feature mimic loss 는 다음과 같이 $ f_{RCNN}(b) $ 및 $ f_{FRCNN}(b) $ 사이의 cosine similarity 에서 다음과 같이 계산된다.

$ L_{mimic} = \sum_{b\in \Omega }^{} [1 - cos (f_{RCNN}(b), f_{FRCNN}(b))] $

여기서 $ \Omega $ 는 mimic training 을 위해 샘플링된 RoI 세트를 나타낸다. SGD Training 에서 입력 이미지가 주어지면 RPN 에 의해 생성된 32 개의 positive region proposal 이 무작위인 $ \Omega $ 로 샘플링 된다. cross-entropy classification loss 는 R-CNN classification head 에 적용되며 $ \Omega $ 단위의 RoI 에서도 계산이 된다. 신경망 훈련은 Faster R-CNN original loss 와 함께 feature mimic loss 및 R-CNN classification loss 에 의해 주도 된다. 새로 도입된 이러한 loss weight 는 원래 Faster R-CNN loss term 의 0.1 배이다. R-CNN 의 해당 모듈과 Faster R-CNN 분기 간의 신경망 매개변수는 백본 신경망, modulated deformable RoIPooling 및 2 fc head 를 포함하여 공유된다. 추론 과정에서는 auxiliary R-CNN branch 없이 Faster R-CNN 신경망만 테스트 이미지에 적용된다. 따라서 추론을 모방한 R-CNN 특징에 대해 추가적인 계산이 필요하지 않다.

(4. Releted Work 는 생략)

5. Experiments

5.1 Experiment Settings

COCO 2017 train 세트의 118k 이미지로 훈련되었으며 ablation 에서는 COCO 2017 vaild 세트의 5k 이미지로 평가를 수행하였다. 또한 COCO 2017 test 세트의 20k 이미지에 대해 성능을 평가한다. Faster R-CNN 및 Mask R-CNN 을 baseline 으로 채택하였으며, ImageNet 의 사전 훈련된 ResNet-50 이 백본으로 사용된다. 또한 신경망을 deformable counterpates 로 전환하기 위해 마지막 3 x 3 regular conv layer 를 modulated deformable conv layer 로 대체한다. aligned RoIPooling 은 deformable RoIPooling 으로 대체된다. 특히 Mask R-CNN 의 경우 7 x 7 및 14 x 14 bin 이 있는 두개의 align 된 RoIPooling layer 가 동일한 bin 번호를 가진 두 개의 deformable RoIPooling 레이어로 대체된다. R-CNN feature mimicking 에서 mimic loss 는 classification 을 위해서만 RoI head 에 적용된다. 또한 하이퍼 파라미터의 선택은 이미지 해상도를 제외하고 Detectron 코드 베이스를 따른다. SGD Training 에서 256 개의 anchor box 및 512 개의 region proposal 이 gradient backpropagation 을 위해 샘플링된다. 신경망은 16 epoch 동안 GPU 당 2개의 이미지를 사용하여 8개의 GPU 에서 학습되었으며, 학습률은 0.02 로 초기화 되고 10번째 및 14번째 epoch 에서 10 으로 나눈다. weight decay 및 momemtum 은 각 $ 10^{-4} $ 와 0.9 로 설정된다.

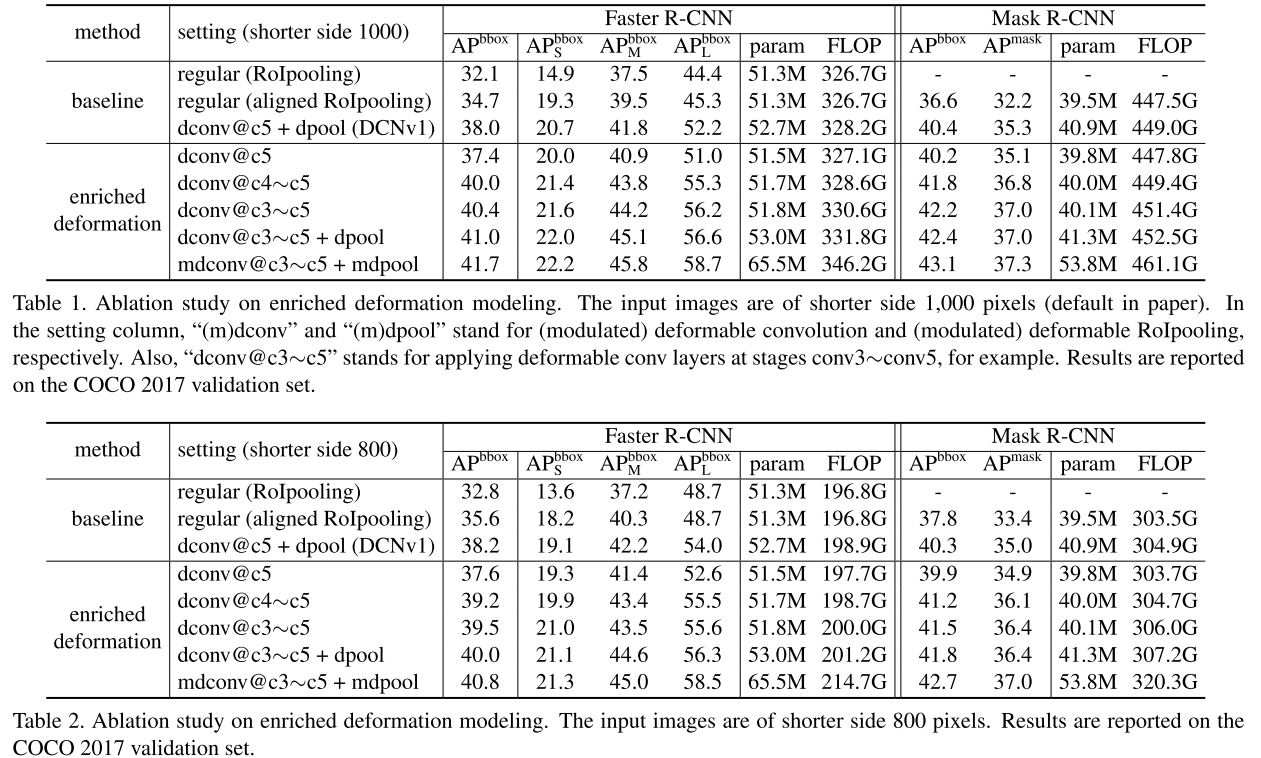

5.2 Enriched Deformation Modeling

enriched deformation modeling 의 효과는 표 1에서 표시된 것처럼 일반 CNN 모듈을 사용한 baseline 은 Faster R-CNN 의 경우 AP(bbox) score 34.7%, Mask R-CNN 의 경우 AP(bbox) 및 AP(mask) score 점수 각각 36.6% 및 32.2% 를 얻었다. DCN v1 baseline 을 위해 conv5 단계에서 3 x 3 conv 의 마지막 3개 layer 와 aligned RoIPooling layer 를 deformable layer 로 대체하여 Deformable ConvNets 을 따른다. 이러한 baseline 은 Faster R-CNN 에 대해 38.0% 의 AP(bbox) score 를 달성하였고, Mask R-CNN 에 대해 각 40.4 % 및 35.3 %의 score 를 달성하였다. 이러한 deformable module 은 정확도를 상당히 향상시킨다.

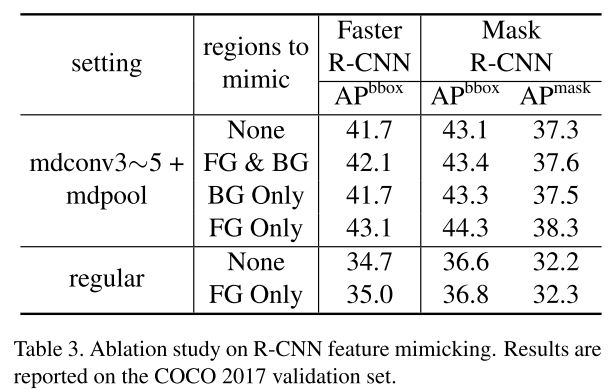

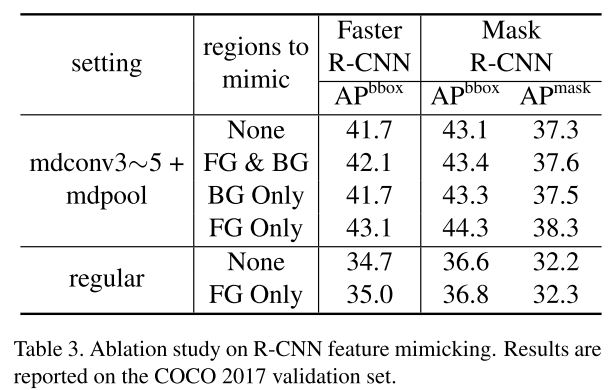

5.3 R-CNN Feature Mimicking

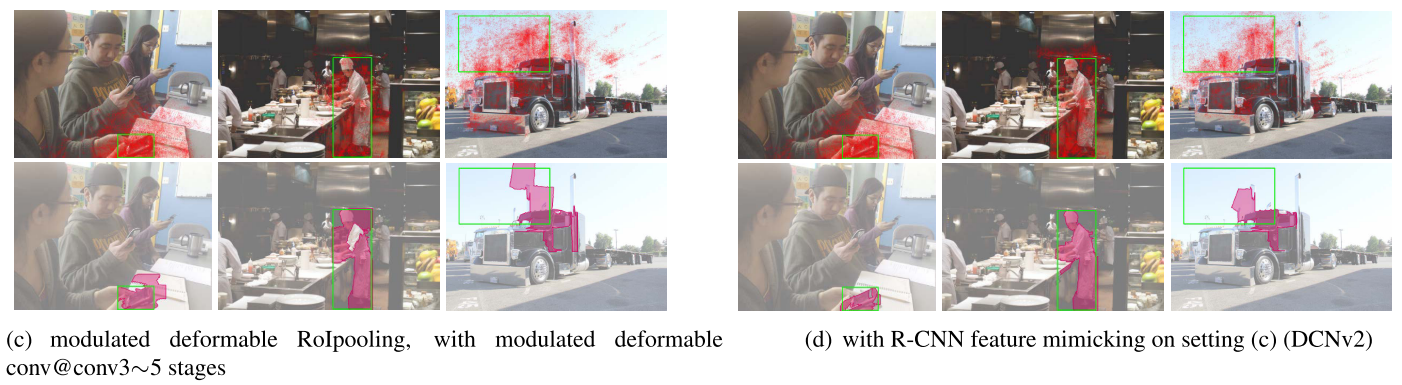

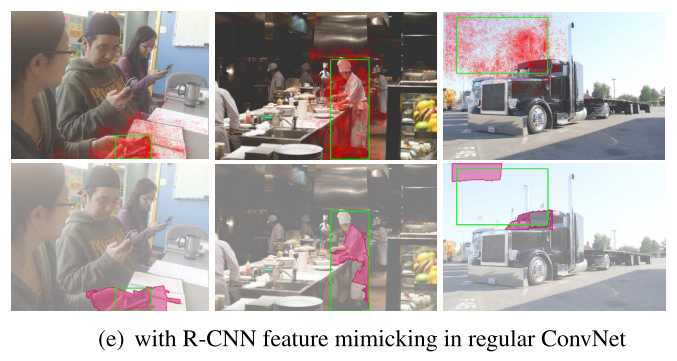

R-CNN Feature Mimicking 실험 결과는 아래 표 3과 같다. enriched deformation modeling 을 통해 R-CNN feature mimicking 은 AP(bbox) 및 AP(mask) 점수를 약 1% ~ 1.4% 정도 향상시켰다. object foreground 에서 positive box feature 를 모방하는 것이 특히 효과적이며 모든 박스를 모방하거나 negative 박스 만 모방할 때의 결과는 훨씬 낮다는 것을 볼 수 있다. 그림 2(c) ~ (d) 에서 볼 수 있듯 featrue mimicking 은 신경망 특징이 object foreground 에 더 초점을 맞추는데 도움이 되며 이는 positive box 에 유용하다는 것을 알 수 있다. negative box 의 경우 신경망은 더 많은 컨텍스트 정보를 활용하는 경향이 있으며 이는 도움이 되지 않는다.

5.4 Application on Stronger Backbones

ResNet-50 을 ResNet-101 m및 ResNext-101 로 대체하여 더 강력한 백본에 대해 DCN v2 를 적용해본 결과는 다음과 같다. DCN v1 항목의 경우 conv 5 layer 에서 일반 3 x 3 conv layer 가 deformable layer 로 대체된다. 또한 RoIPooling 도 deformable RoIPooling 으로 대체된다. DCN v2 항목의 경우 conv3 - conv5 layer 에서 모든 3 x 3 conv layer 는 modulated deformable convolution 이며 R-CNN feature mimic loss 와 함께 deformable RoIPooling 이 사용된다. DCN v2 는 모든 신경망 백본에서 일반 ConvNet 및 DCN v1 을 상당히 능가하는 것으로 나타났다.

6. Conclusion

기하학적 변형 모델링에서 Deformable ConvNet의 우수한 성능에도 불구하고 spatial support 는 관심 영역을 훨씬 넘어 확장되어 신경망의 특징이 관련없는 이미지 콘텐츠의 영향을 받는다.

이 논문에서는 모델링 능력을 높이고 학습을 강화하여 관련 이미지 영역에 집중하는 능력이 향상되도록 Deformable ConvNets의 재구성을 제시하였으며, 객체 탐지 및 인스턴스 분할을 위한 COCO 벤치 마크에서 상당한 성능 향상을 얻었다.