[Paper Review] HuMMan, Multi-Modal 4D Human Dataset for Versatile Sensing and Modeling

Paper : https://arxiv.org/pdf/2204.13686.pdf

Project page : https://caizhongang.github.io/projects/HuMMan/

HuMMan

HuMMan: Multi-Modal 4D Human Dataset for Versatile Sensing and Modeling Zhongang Cai* Daxuan Ren* Ailing Zeng* Zhengyu Lin* Tao Yu* Wenjia Wang* Xiangyu Fan Yang Gao Yifan Yu Liang Pan Fangzhou Hong Mingyuan Zhang Chen Change Loy Lei Yang^ Ziwei Liu^ Shang

caizhongang.github.io

오늘 살펴본 논문은 ECCV 2022에 게재된 "HuMMan, Multi-Modal 4D Human Dataset for Versatile Sensing and Modeling" 라는 논문입니다. Multi-Modal 4D에 대한 궁금증이 생겨 간단히만 살펴보았습니다.

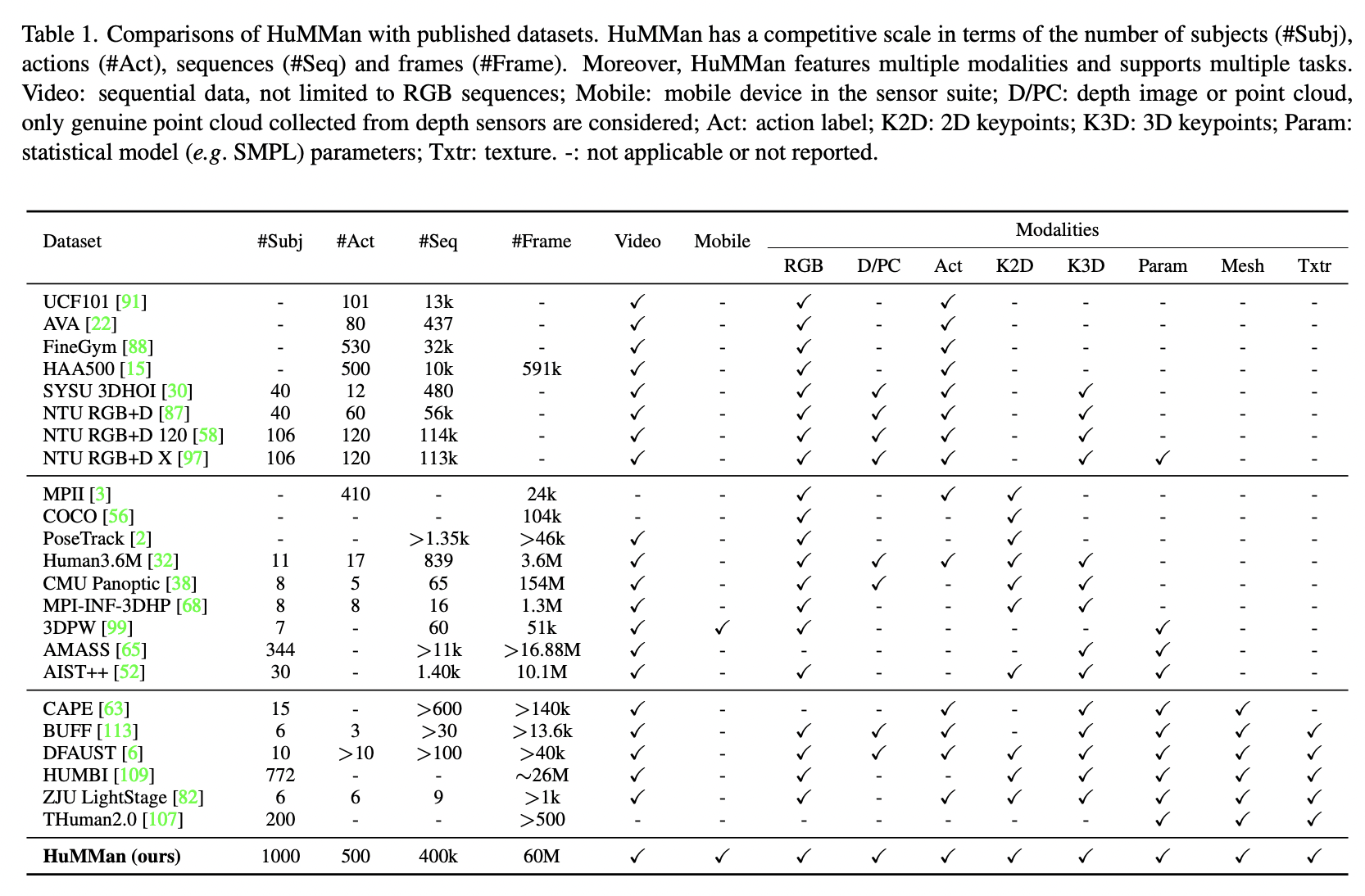

일단 4D human sensing 및 modeling은 vision 및 graphic 분야에서 fundamental task 이며, 다양한 센서와 알고리즘의 발전으로 인해 보다 versatile datasets에 대한 수요가 증가하고 있다고 합니다. 본 논문에서는 1000명의 사람들을 이용하여 400k 시퀀스 및 60M 개의 프레임이 있는 large-scale multi-model 4D human dataset인 HuMMan 데이터세트를 생성했습니다. 아래 사진과 같이 color image, point cloud, keypoint, SMPL parameter, textured mesh를 포함합니다. 또한 기본적인 500개의 action으로 구성되며, action recognition, pose estimation, parametric human recovery, textured mesh reconstruction 과 같은 여러 작업이 가능합니다.

HuMMan 데이터세트는 아래와 같은 4가지 속성을 제공합니다.

Multiple Modalities

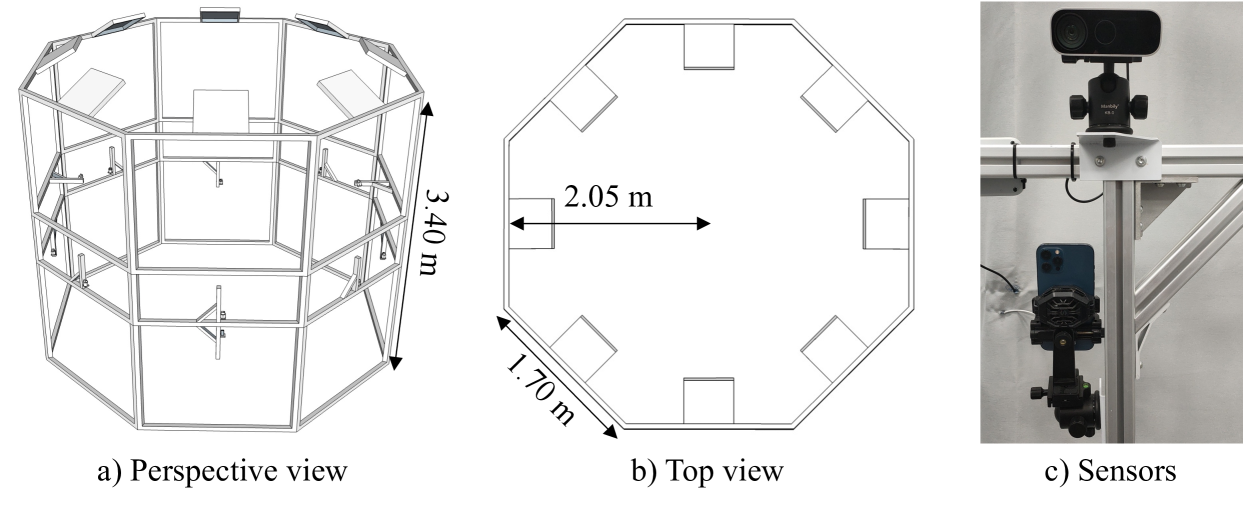

10개의 동기화된 RGB-D 카메라를 이용하여 데이터세트를 구축하였으며, video 및 depth sequence를 모두 capture 하며, 모든 데이터와 주석들은 시간적으로 동기화 되지만 3D 데이터와 주석은 공간적으로 정렬된다고 합니다.

Mobile Devices

요즘 3D 센서의 발달로 최근 몇 년 동안 모바일 장치에서 depth camera 또는 저전력 LiDAR를 이용하는데, 모바일 장치로 수집된 데이터의 부족 문제를 해결하기 위해 데이터를 수집할 때 LiDAR가 내장된 mobile phone을 추가했다고 합니다.

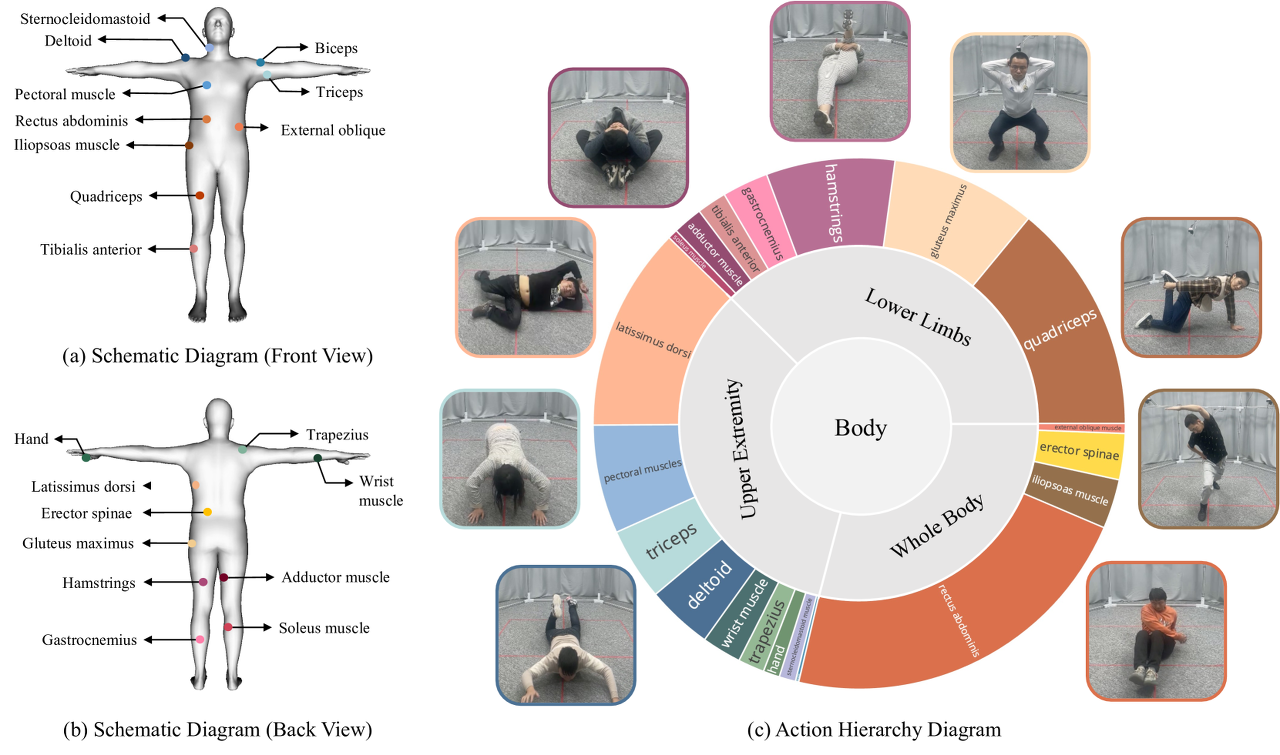

Action Sets

인간 행동 인식 연구를 위해 HuMMan 데이터세트를 설계했습니다. 일상적인 활동을 경험적으로 선택하는 대신 해부학적 관점에서 신체의 움직임을 구동하는 근육 기반으로 체계적으로 행동을 나누어놓았습니다. 주요 muscle group으로 나누어 500개의 action을 설계했습니다.

Multiple Tasks

action recognition, 2D and 3D pose estimation, 3D parametric human recovery, and textured mesh reconstruction 작업을 위한 전체 기준 및 벤치마크 결과를 제공합니다.

아래 보시는 사진을 보면 현존하는 데이터세트들과 비교했을 때 multi-task를 위한 압도적인 데이터세트라는 것을 볼 수 있습니다. Human36M 데이터세트도 많이 쓰이는 편인데 이 데이터는 사람 종류가 11명 밖에 안되는데, HuMMan 데이터는 사람 종류도 1000개나 되고, 무엇보다 액션 종류가 500개나 되서 마음이 편안해지네요. color image 부터 시작해서 textured mesh 까지 포함하게 되는 데이터는 이게 최초 인 듯 합니다.

하드웨어는 아래와 같이 구성되었다고 합니다.

Action Set은 다음과 같습니다. muscle 기준으로 행동을 나눠놓은게 대박인듯 합니다. (a), (b)에서 schematic diagram은 피트니스 및 요가 전문가는 주요 근육을 식별하고, 이러한 근육과 관련된 표준 동작 목록을 작성했다고 합니다.

Subject 같은 경우 아래와 같습니다.

여기서 말하는 subject는 사람 종류 라고 보시면 되는데, Diversity을 고려할 때 성별, 연령, 체형(키, 몸무게), 민족성을 폭 넓게 커버하는 1000명의 사람들로 구성되어있고, 자연스러운 모습을 위해 일상복을 입도록 지시받았다고 합니다.

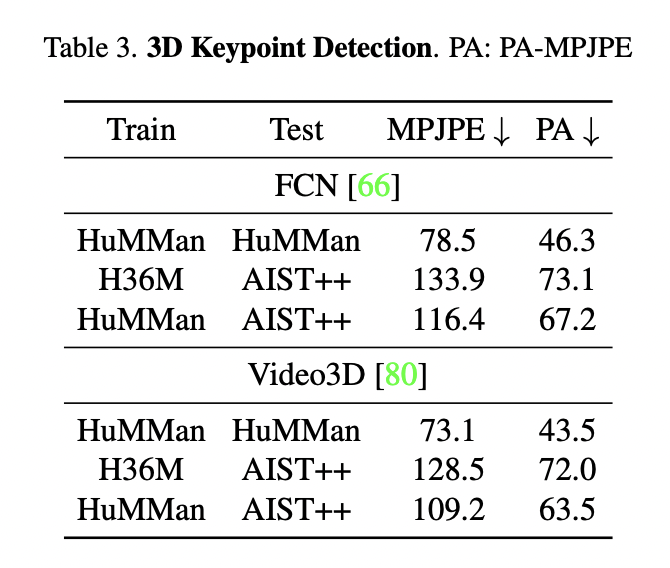

이러한 HuMMan 데이터세트를 사용하여 3D keypoint Detection 결과는 아래와 같습니다. (논문에 action recognition, 3d parametric human recovery 등 다른 분야에 대한 실험 결과도 있으니, 궁금하신 분들은 직접 논문을 참고하시기 바랍니당 ㅎㅎ)

Train H36M, Test H36M 도 궁금한데 이에 대한 결과는 없어서 조금 아쉽네요. 아마 H36M 으로만 train, test를 진행하면 HuMMan 으로만 train, test를 진행한 결과보다 낮아서 적지 않은 걸까요? 아니면 두 데이터세트에 대한 결과를 AIST++ 데이터세트로 평가해놔서 쓸 필요가 없었던 걸까요? 일단 각 H36M, HuMMan 데이터세트로 학습시킨 모델을 각각 AIST++ 데이터세트로 test 한 결과는 HuMMan 데이터세트가 더 성능이 좋네요.

이러한 4D multi-modal 대규모 데이터세트의 공개로 인해 pose estimation, mesh, textured mesh 에 대한 연구들이 더 활발히 일어나면 정말 좋겠습니다. 본 논문의 discussion 부분에서도 인간을 감지하고 모델링 하기 위한 더 나은 알고리즘의 개발을 촉진했으면 좋겠다고 말하고 있네요.